🚀 Break Inertia. AI Your Business in 3 Days with our Free Bot! Book your 15min Demo Now!

AI Chatbot: vom Guten zum Großartigen!

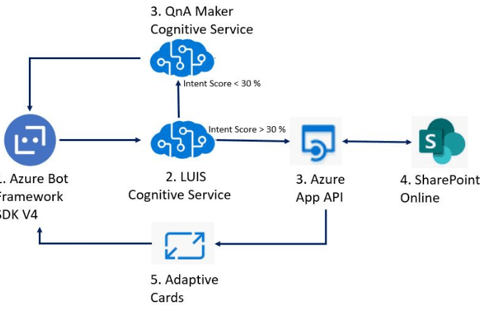

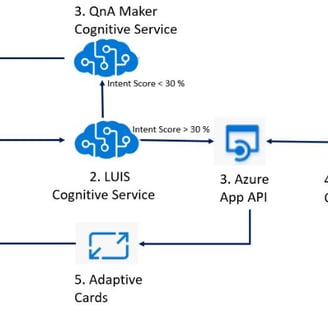

Das Azure Bot Framework SDK V4 wird zur Entwicklung von Bots verwendet, wobei LUIS die Benutzerabsicht interpretiert und QnA Maker datengesteuerte Antworten liefert. SharePoint Online dient als Inhaltsdatenbank, während Adaptive Cards interaktive Dialoge erstellen. Zusammen bilden sie ein integriertes System für anspruchsvolle Bot-Interaktionen auf Azure. Ist das nicht großartig?

3/29/20244 min read

The typical development pipeline for einen auf Azure basierenden Chatbot umfasst die Nutzung von Azure Cognitive Services zur Dokumenteneingabe. Dieser Prozess beinhaltet das Zerlegen von Dokumenten in handhabbare Stücke, das Generieren von Embeddings aus diesen Stücken und die Integration dieser Embeddings in den Chatbot. Diese Integration stellt sicher, dass der Chatbot effektiv auf Benutzerinteraktionen reagieren kann, basierend auf den verarbeiteten Informationen.

Laut Microsoft ist dies eine überzeugende Pipeline, um eine Generative AI-Anwendung schnell hochzuskalieren.

Führende Plattform für Informationsretrieval und Suche in RAG

Azure AI Search, eine AI-gestützte Plattform für Informationsretrieval, unterstützt Entwickler beim Aufbau reicher Sucherfahrungen und generativer AI-Apps, die große Sprachmodelle mit Unternehmensdaten kombinieren. Implementieren Sie Suchfunktionen für jede mobile oder Suchanwendung innerhalb Ihres Unternehmens oder als Teil von Software as a Service (SaaS)-Apps.

Das Azure Bot Framework SDK V4 bildet die Grundlage für die Bot-Entwicklung auf Azure und bietet die notwendigen Bibliotheken und Tools für die Aufgabe. LUIS, als Teil der kognitiven Dienste von Azure, interpretiert Benutzereingaben, um Absichten zu erkennen und Entitäten zu extrahieren. Wenn die Vertrauenswürdigkeit von LUIS bezüglich der Absicht unter 30% liegt, wird die Anfrage an QnA Maker weitergeleitet, der Antworten aus vorliegenden Daten wie FAQs generiert. SharePoint Online fungiert als Inhaltsdatenbank, die von LUIS genutzt wird, wenn die Vertrauenswürdigkeit der Absicht über 30% liegt, um Dateninteraktionen zu verwalten. Schließlich präsentieren Adaptive Cards interaktive Inhalte innerhalb des Bot-Dialogs, indem sie Daten aus SharePoint Online nutzen und die Benutzerinteraktion erleichtern.

Document Search Bot Using Azure Bot Framework

Das eigentliche Problem besteht jedoch in der Effektivität dieser Pipeline bei der Bereitstellung erstklassiger Chatbots. Bevor wir diese Frage basierend auf unserer Erfahrung mit Kunden beantworten, lassen Sie uns definieren, was Exzellenz bedeutet.

Aus der Perspektive der Benutzererfahrung eines Chatbots ist ein „großartiger“ Bot einer, der mehr als 8 von 10 Mal relevante Antworten liefert. Ein Genauigkeitsgrad von über 80% ist für Kundenservice- und KnowledgeBot-Anwendungen äußerst wünschenswert.

Basierend auf unserer Erfahrung erreicht die oben genannte „Standard“-Pipeline typischerweise eine Genauigkeitsrate im Bereich von maximal 60% bis 70%. Es ist wichtig zu betonen, dass die Wahl des Large Language Models (LLM) am wenigsten für diese Einschränkung verantwortlich ist!

Von Gut zu Großartig!

Um eine Genauigkeit von über 80% bei Chatbot-Antworten zu erreichen, ist eine erhebliche Anpassung in fast allen Schritten der Pipeline erforderlich. Hier ist ein umfassender Ansatz:

1. Strukturbewusste benutzerdefinierte Eingabe: Nutzen Sie fortschrittliche Techniken und Bibliotheken, die die ursprüngliche Struktur der Dokumente während der Umwandlung in Text erhalten. Dieser Schritt ist entscheidend, um die Integrität und den Kontext der Informationen zu wahren und so Ungenauigkeiten zu minimieren, die durch Strukturverlust verursacht werden.

2. Intelligente Zerlegung & fortschrittliche Embeddings: Implementieren Sie inhaltsbewusste Zerlegungsstrategien, die sich auf die Relevanz von Textsegmenten für die vom Chatbot erwarteten Anfragen konzentrieren. Optimieren Sie die Größe dieser Stücke für eine effiziente Verarbeitung, ohne den Kontext zu verlieren. Aktualisieren Sie auf das neueste Embeddings-Modell, wie zum Beispiel ADA-003, das Verbesserungen gegenüber seinen Vorgängern bietet, und passen Sie es an die spezifischen Bedürfnisse des Datensatzes an.

3. Erweitertes Kontext-Metadaten: Gehen Sie über die einfache Erfassung von Metadaten hinaus, indem Sie detaillierte Kontext-Metadaten mit den Textstücken integrieren. Diese Metadaten sollten reichhaltig und beschreibend sein, um es den Embeddings zu ermöglichen, ein tieferes Verständnis des Kontextes, Zwecks und der Relevanz des Dokuments zu erfassen.

4. Hybride Similaritätssuche mit benutzerdefiniertem Re-Ranking: Entwickeln Sie einen anspruchsvolleren Mechanismus zur Similaritätssuche, der verschiedene Suchmethodologien kombiniert, um die relevantesten Textstücke zu identifizieren. Passen Sie den Re-Ranking-Prozess an, um sicherzustellen, dass sowohl der Inhalt des Stückes als auch seine kontextuelle Relevanz berücksichtigt werden, und bringen Sie die am besten geeigneten Antworten in den Vordergrund.

Es ist unwahrscheinlich, dass das relevanteste Stück als Top 1 zurückkommt, aber es ist wahrscheinlich, dass es in den Top 100 zurückkehrt.

5. Verfeinerte LLM-Prompt-Engineering: Engagieren Sie sich im detaillierten Prompt-Engineering mit dem Large Language Model, um dessen Fähigkeit zu verbessern, die genauesten und relevantesten Antworten auszuwählen und zu formulieren. Dies umfasst die Anpassung von Prompts, um die strukturierten und reich kontextualisierten Daten zu nutzen und so die Effektivität des LLM zu maximieren.

Das Optimieren des Kontexts für eine kleine Anzahl von Stücken, speziell weniger als fünf, innerhalb eines Large Language Model (LLM)-Kontextaufrufs ist sowohl machbar als auch vorteilhaft.

6. Interaktive Bot-Erfahrung mit Human-in-the-Loop: Erstellen Sie eine interaktivere und menschlichere Chatbot-Erfahrung. Dies kann die Entwicklung einer benutzerdefinierten Chatbot-Anwendung umfassen, die Benutzern Optionen zur Verfeinerung ihrer Anfragen oder zur Auswahl aus mehreren Antworten bietet. Die Integration eines Human-in-the-Loop-Ansatzes, wo erforderlich, kann auch dazu beitragen, die Genauigkeit und Relevanz von Antworten kontinuierlich zu verbessern, basierend auf Benutzerfeedback und Interaktionen.

7. Kontinuierliches Lernen und Optimierung: Implementieren Sie eine Feedback-Schleife, bei der das System aus jeder Interaktion lernt und die Genauigkeit von Zerlegung, Embeddings und Antwortgenerierung kontinuierlich verbessert. Dies erfordert fortgeschrittene maschinelle Lerntechniken und möglicherweise manuelle Aufsicht, um sicherzustellen, dass der Chatbot sich weiterentwickelt und sich den Bedürfnissen der Benutzer im Laufe der Zeit anpasst.

Durch die Anpassung dieser Pipeline-Schritte können Sie die Genauigkeit und Effektivität eines Chatbots erheblich verbessern, sodass er in der Lage ist, Antworten mit mehr als 80% Genauigkeit zu liefern. Dieser maßgeschneiderte Ansatz stellt sicher, dass der Chatbot nicht nur die Erwartungen an Benutzerinteraktionen erfüllt, sondern diese sogar übertrifft, und eine nahtlose und effiziente Benutzererfahrung bietet.

Die Rolle von Pandorabot.io bei der Verbesserung von Chatbot-Erlebnissen

🧠 KnowledgeBot 💰SalesBot 🛠️ ServiceBot 👁️🗨️VisionBot

Für Unternehmen, die das volle Potenzial von AI in Kundeninteraktionen nutzen möchten, ist Pandorabot.io eine erstklassige Lösung. Spezialisiert auf die Erstellung maßgeschneiderter Chatbots bietet Pandorabot.io eine Plattform, auf der Unternehmen Chatbots entwickeln können, die nicht nur auf ihre spezifischen Bedürfnisse abgestimmt sind, sondern sich auch mit ihnen weiterentwickeln können. Unsere Chatbots sind darauf ausgelegt, nuancierte, branchenspezifische Interaktionen zu bieten, eine nahtlose Integration mit Geschäftssystemen sicherzustellen und modernste Datensicherheitsmaßnahmen zu implementieren. Mit Pandorabot.io können Unternehmen ein Chatbot-Erlebnis gewährleisten, das die Kundenbindung verbessert, den Markenruf stärkt und die betriebliche Effizienz steigert.